深入剖析Hadoop框架 大数据处理的基石

Hadoop是一个开源分布式计算框架,由Apache软件基金会开发,旨在从单一服务器扩展到数以千计的机器,每台机器都提供本地计算和存储。其核心设计灵感来源于Google的MapReduce和Google File System(GFS)论文,为海量数据的存储和处理提供了一个可靠、可扩展的平台。

一、Hadoop的核心组件

Hadoop生态系统主要由两个核心组件构成:Hadoop Distributed File System(HDFS)和MapReduce。

- HDFS(Hadoop分布式文件系统)

- 设计目标:用于在廉价硬件上存储超大规模数据集,并提供高吞吐量的数据访问。

- 架构:采用主从(Master/Slave)架构。

- NameNode(主节点):管理文件系统的命名空间(元数据),如文件名、目录结构、文件块位置等。一个集群通常只有一个活跃的NameNode,负责协调客户端对文件的访问。

- DataNode(从节点):存储实际的数据块。集群中有多个DataNode,它们负责响应客户端的读写请求,并执行来自NameNode的块创建、删除和复制指令。

- 数据复制:HDFS通过将文件分割成固定大小的块(默认128MB或256MB)并在多个DataNode上复制(默认3份)来实现容错性。即使某个节点故障,数据也不会丢失。

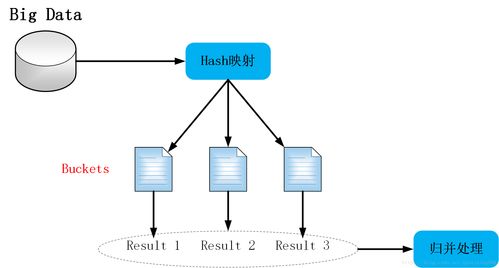

- MapReduce(分布式计算模型)

- 编程模型:将计算任务分为两个主要阶段——Map(映射)和Reduce(归约)。

- Map阶段:输入数据被分割成独立的块,由多个Map任务并行处理。每个Map任务处理一个数据块,并输出一组中间键值对(key-value pairs)。

- Shuffle与Sort阶段:系统自动将Map输出的中间结果根据key进行排序和分组,然后分发到相应的Reduce任务节点。此过程对用户透明,但至关重要。

- Reduce阶段:每个Reduce任务接收属于特定key的所有中间值,对其进行归约(如求和、计数、聚合等),并产生最终输出。

- 执行框架:由JobTracker(主节点,负责调度和监控作业)和TaskTracker(从节点,执行具体任务)管理。在Hadoop 2.x及以后版本中,被更通用的资源管理框架YARN所取代。

二、Hadoop的数据处理流程(以经典MapReduce为例)

一次完整的数据处理作业通常遵循以下步骤:

- 输入与分片:客户端提交作业,输入数据(通常存储在HDFS上)被逻辑划分为多个InputSplit(输入分片)。每个分片由一个Map任务处理。

- Map阶段:多个Map任务并行启动。每个任务读取其分配的分片,逐条记录应用用户定义的

map()函数,生成中间键值对并写入本地磁盘。 - Shuffle与Sort:这是MapReduce的“心脏”。Map任务完成后,其输出根据key进行分区(决定由哪个Reduce处理),然后通过HTTP被对应的Reduce任务拉取(Fetch)。在Reduce端,来自所有Map任务的、属于同一分区的数据会按键进行排序和合并。

- Reduce阶段:排序后的中间数据被输入用户定义的

reduce()函数。Reduce任务对每个唯一的key及其对应的值列表进行处理,产生最终结果。 - 输出:Reduce的输出通常写回HDFS,每个Reduce任务生成一个独立的输出文件。

三、Hadoop的优势

- 高可靠性:数据多副本存储和计算任务自动重试机制,保障了硬件故障下的数据安全与任务完成。

- 高可扩展性:可通过简单地增加商用服务器节点来线性扩展集群的存储和计算能力。

- 高容错性:能够自动处理节点故障,将失败的任务重新调度到其他健康节点执行。

- 成本效益:构建在廉价的商用硬件集群上,降低了海量数据存储与处理的成本。

- 适合批处理:尤其擅长处理离线、海量的历史数据集,进行复杂的批量分析和ETL(提取、转换、加载)操作。

四、Hadoop生态系统的演进与补充

随着大数据技术的发展,Hadoop的核心MapReduce因其磁盘I/O开销大、延迟高等问题,在某些场景下(如交互式查询、流处理)显得力不从心。因此,以YARN(Yet Another Resource Negotiator)为核心的Hadoop 2.x应运而生。

- YARN:将资源管理与作业调度/监控功能分离,成为一个通用的集群资源管理平台。这使得Hadoop可以运行除MapReduce之外的其他计算框架,如:

- Apache Spark:基于内存计算的快速通用引擎,支持流处理、SQL查询、机器学习和图计算,常作为MapReduce的替代或补充。

- Apache Hive:提供SQL接口(HiveQL)将查询转换为MapReduce/Tez/Spark作业,用于数据仓库汇总和查询。

- Apache HBase:建立在HDFS之上的分布式、可扩展的NoSQL数据库,支持实时读写随机访问。

- Apache Flink:统一的流批处理计算框架。

- Apache Tez:旨在加速Hive、Pig等作业执行的DAG(有向无环图)计算框架。

五、与展望

Hadoop框架,特别是其HDFS和YARN,构成了现代大数据平台的基石。其核心思想——将计算移至数据所在位置、通过数据冗余实现容错——深刻影响了后续的大数据技术发展。尽管原生MapReduce在实时性要求高的场景中使用减少,但整个Hadoop生态系统通过集成Spark、Flink等更高效的计算引擎,以及Hive、HBase等上层工具,依然在企业级数据湖、大规模批处理、历史数据分析等领域发挥着不可替代的作用。理解Hadoop的基本原理,是深入大数据技术领域的必备基础。

如若转载,请注明出处:http://www.hanzhengroom.com/product/56.html

更新时间:2026-02-21 00:29:29