一招制胜 数据处理提速5倍的金融企业数据开发秘诀

在竞争日益激烈的金融行业,数据处理速度往往直接决定企业的决策效率和市场反应能力。传统的金融数据开发流程常常因技术堆栈复杂、数据孤岛严重、计算资源调度不灵活等问题而步履维艰。仅仅通过引入并系统化应用一个核心策略,许多领先的金融机构已经成功地将数据开发效率提升了数倍,甚至达到惊人的5倍提速。这一招,就是全面拥抱并实施 “一体化云原生数据湖仓架构与低代码/自动化数据流水线”。

核心策略解析

这一招并非单一工具,而是一个紧密结合的体系化方法:

1. 构建云原生数据湖仓(Lakehouse)作为统一基石

* 打破孤岛,统一存储: 告别过去交易数据、客户行为数据、市场数据等分散在不同数据库、数据仓库和数据湖中的局面。利用云对象存储(如AWS S3、Azure Blob Storage)的弹性与低成本优势,构建一个能够同时容纳原始数据、清洗后数据、特征数据和模型数据的单一可信数据源。这消除了大量的数据搬迁和格式转换时间。

- 事务与分析的统一: 采用Delta Lake、Apache Iceberg或Apache Hudi等开源表格式,在数据湖之上赋予ACID事务、数据版本管理、模式演进等数据仓库级的管理能力。这意味着数据工程师和数据分析师可以在同一份实时更新的数据上工作,开发即用,无需等待漫长的ETL(抽取、转换、加载)过程。

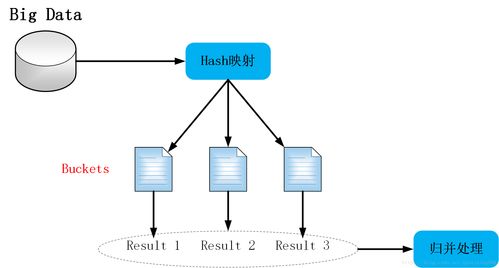

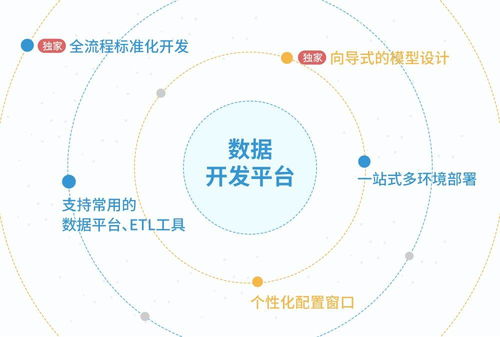

2. 部署低代码/自动化数据流水线开发平台

* 可视化编排,降低门槛: 利用如Apache Airflow、Prefect或云厂商提供的托管工作流服务(如AWS Step Functions, Google Cloud Composer),通过拖拽和配置的方式,直观地设计复杂的数据依赖关系与处理流程。业务分析师和初级数据开发者也能快速参与构建数据产品,极大释放了资深数据工程师的生产力。

- 智能调度与监控: 平台自动处理任务调度、依赖管理、错误重试和报警通知。开发者从繁琐的运维工作中解放出来,专注于核心的业务逻辑开发。

- 模板化与可复用组件: 将常见的金融数据处理模式(如市价重估、风险因子计算、客户分群、反欺诈特征生成)封装成可复用的标准化组件或模板。新项目的开发不再是“从零开始”,而是“积木式搭建”,这是实现5倍提速的关键杠杆点。

提速5倍的效果体现

- 开发周期极速缩短: 过去需要一个团队耗时数周才能上线的新数据报表或模型特征,现在可能由1-2人在几天内完成。需求响应从“月”级进入“天”甚至“小时”级。

- 运维复杂度断崖式下降: 统一的架构和自动化流水线,使得系统监控、问题排查和数据血缘追溯变得异常清晰,将运维负担降低了70%以上。

- 资源利用效率飙升: 云原生架构支持计算与存储分离,以及弹性伸缩。数据处理任务可以按需申请大量资源快速完成,然后立即释放,避免了本地集群常年的资源闲置与排队等待,计算成本反而可能下降。

- 协同效率大幅提升: 数据科学家、分析师、工程师在统一、实时、可信的数据基底上协作,沟通成本降低,迭代速度加快。

实施路径建议

- 评估与规划: 盘点现有数据资产与技术栈,选择最适合自身云环境和团队的Lakehouse表格式与自动化调度工具。从小型但关键的业务场景(如每日监管报表自动化)开始试点。

- 搭建核心平台: 建立统一的云数据存储层,部署工作流调度平台,并着手将最耗时、最重复的数据处理任务迁移和重构。

- 沉淀与赋能: 在实战中,不断将最佳实践沉淀为标准化组件和模板,建立内部知识库,并对团队进行系统化培训,推广低代码开发文化。

- 迭代与扩展: 将成功模式复制到更多的业务线,并持续优化平台能力,例如集成数据质量管理、数据目录等,形成完整的数据中台能力。

结论

对于金融企业而言,数据开发的竞争本质上是一场效率的竞争。“一体化云原生数据湖仓架构与低代码/自动化数据流水线”这一组合策略,通过技术架构的统一化和开发过程的自动化、模板化,直击传统开发模式的痛点。它不仅仅是技术的升级,更是工作模式和协作方式的革新。成功实施这一招,金融企业收获的将不仅是5倍的数据开发速度提升,更是构筑未来数据驱动智能决策的坚实核心能力。

如若转载,请注明出处:http://www.hanzhengroom.com/product/45.html

更新时间:2026-02-28 21:03:12